「一般人の被害が増加」卒アル写真を使った“性的ディープフェイク”

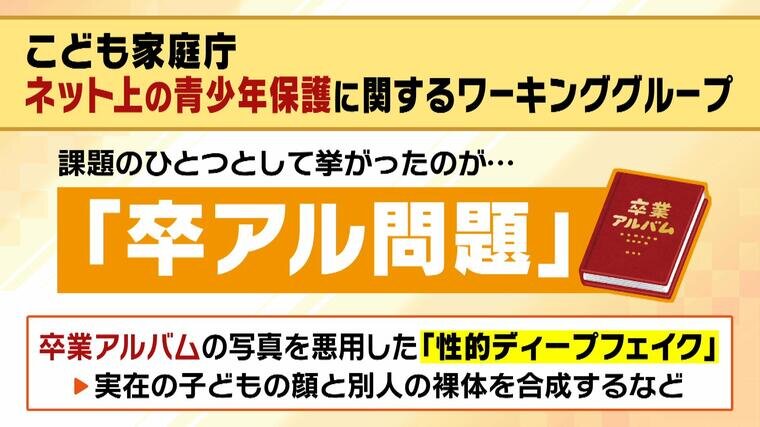

こども家庭庁のネットの青少年保護に関するワーキンググループの中で、課題の1つとして挙がったのが「卒アル問題」。卒業アルバムの写真を悪用した“性的ディープフェイク”=実在の子どもの顔と別人の裸体を合成するなどの手口が問題になっています。今回共有されていたものの中には、盗撮画像以外に「別人の裸+児童の顔」のディープフェイクも見つかったということです。

こうした生成AIを使った“性的ディープフェイク”について守永氏は、「以前は芸能人やアスリートの被害が多かったが、この1~2年で一般人の被害が増加している」と指摘。小学校の卒業アルバムを使ったものも出ていると言います。さらに、「画像1枚から、自ら服を脱ぐなどの性的な動画を作ることも可能」だということです。

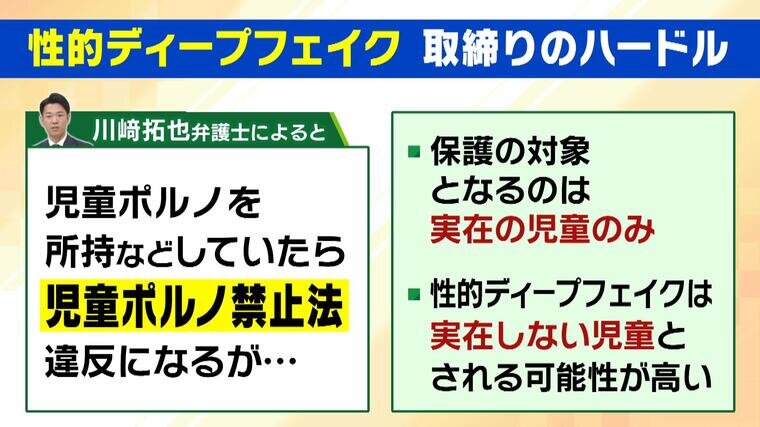

ただ、“性的ディープフェイク”の取締りには、さまざまなハードルがあるようです。川﨑拓也弁護士によると、「児童ポルノを所持などしていたら、児童ポルノ禁止法違反になる」ということですが、「保護の対象となるのは『実在の児童のみ』であり、性的ディープフェイクは『実在しない児童』とされる可能性が高い」と言います。

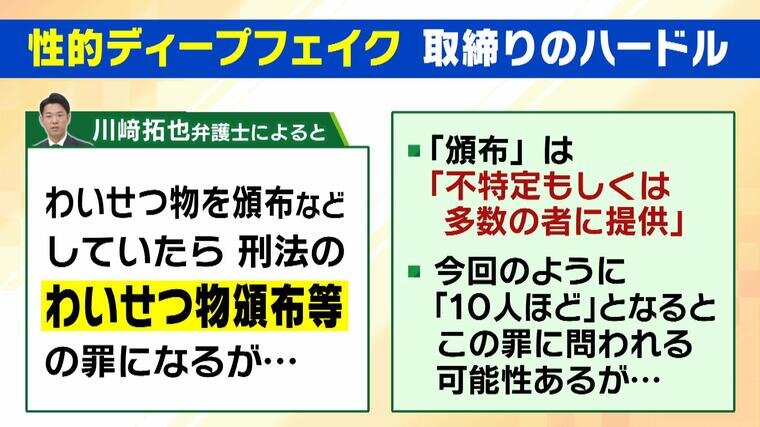

さらに、「わいせつ物を頒布などしていたら、刑法のわいせつ物頒布等の罪になる」ということですが、ここで言う“頒布”とは「不特定もしくは多数の者に提供」した場合を言い、具体的に何人なのかは明確に決まっていないそうです。今回のように“10人ほどで共有”というケースでは、この罪に問われる可能性もある一方、より少ない人数で共有していた場合はこの罪にあたらない可能性も出てくるということです。