生成AIなどを悪用し実在する児童などの性的画像を作成する「性的ディープフェイク」の被害が深刻化していることを受けて、警察庁は被害相談の状況を初めて公表し、注意を呼びかけました。

実在する児童や女性などの画像を生成AIや画像加工アプリの技術を悪用して性的な画像を作り出す「性的ディープフェイク」。誰でも簡単に被害者にも加害者にもなってしまうことから大きな問題となっています。

「性的ディープフェイク」による子どもの被害が深刻化していることを受け、警察庁はきょう(18日)、SNSなどでの拡散が犯罪や人権被害にもつながるとして注意を呼びかけました。

警察庁によりますと、去年、18歳未満の画像を使った性的ディープフェイクに関する全国の相談や通報は110件で、このうち7件は「名誉毀損」などの疑いで検挙されたということです。

今年に入ってから9月末までに寄せられた相談は79件で、去年と同じ時期と比べて微増傾向にあり、このうち検挙は4件、補導は6件でした。

被害者は、▼高校生が25件(31.6%)、▼中学生が41件(51.9%)、▼小学生が4件(5.1%)で、被害者と加害者の関係は、およそ半数の53.2%が同級生や同じ学校の生徒でした。

警察庁は具体的な事例を紹介。ある男子中学生は、同級生の女子生徒がSNSに投稿した画像を生成AIで裸の画像に加工し、ほかの同級生に販売していました。

別の男子中学生らは、学校のタブレット端末から行事のアルバムに載っていた同級生の女子生徒の写真を生成AIで性的な画像に加工。複数の同級生にグループチャットで拡散したとして補導されたということです。

警察庁は性的ディープフェイクについて、「体の部分は自分のものではないとはいえ、被害児童が受ける心の傷は想像以上に大きい」としたうえで、「被害者に寄り添いつつ、法と証拠に基づき、適切に対処する」とし、今後も関係省庁と連携して対策を進めていくとしています。

注目の記事

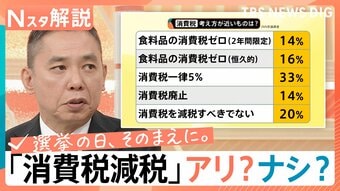

「戦後最短」真冬の選挙戦 消費税減税でほとんどの各党“横並び”物価高に有効か?「食料品の消費税ゼロ」飲食店の困惑 穴埋め財源も不透明のまま…【サンデーモーニング】

“働いても働いても”…抜け出せない過酷な貧困 非正規雇用890万人 30年で広がった格差社会 政治の責任は?【報道特集】

衆議院選挙 序盤の最新情勢を徹底解説 自民「単独過半数」うかがう勢い 一方で中道は大幅減か・・・結果左右する「公明票」の行方とは【edge23】

今季も驚き“ニセコ価格”カツカレー3000円でも利益は180円、VIPに人気のケータリング1回30万円でも“安い”ワケ…北海道民には遠いリゾートの経済の仕組み

5年前は部員3人「声を出すのが恥ずかしく⋯」センバツ初出場・高知農業、21世紀枠で掴んだ“夢舞台”への切符【選抜高校野球2026】

政策アンケート全文掲載【衆議院選挙2026】