「AI」にも“偏見”?その理由とは

山本キャスター:

この偏り、性別だけではなく「人種」でもありそうなんです。

「モデル」と入力して出てきた画像。全て「白人」女性というふうになっているんですね。

「ラッパー」と入力すると、「黒人」しか出てこないという結果になりました。

ちなみに、「日本人男性・日本人女性」と入力すると、男女ともに「和服を着た姿」となっているんですね。

小川キャスター:

こうした“偏り”というのは改善されるべきものなのか、どう受け止めたらいいでしょうか。

宮田氏:

ここに出てる日本人男性、日本人女性はいつの時代の人なんだ、ということで、おそらくデータベースの読み込む対象が偏ってるだろう、と。こういった改善点は少なくともある。

小川キャスター:

「Midjourney」は欧米の企業ですから、欧米でのイメージの日本人という形がこれで出てくるということですか。

宮田氏:

あるいは、画像リソースにそもそも偏りがあるんじゃないか、と。ChatGPTも含めてデータベース、参照するものを、より「多様」にかつ「多く」することによって、偏りを防いでいくことだったり、あるいは、偏見を助長しないようなアルゴリズムを組み込む、ということもやってます。

もう一つは「透明性」です。「どこから学んでるのか」ということを開示していくことや、それに対して「これおかしいですよ」と我々が思ったら、フィードバックをかけていくことで、継続的な改善をしていくということです。

一方で、現実問題として、例えば「職業イメージ」というもの、我々が生成してるような“人が作るイメージ”とか“広告”というものが歪んでる場合は、AIをどんなに頑張ったとしても、補正しきれない部分があるので、現実そのものも歪んでいる、ということを前提にして考える必要があるだろうと。

チャットGPTに聞いてみた「AIは偏見を持つ?」

山本キャスター:

ちなみに、話題の対話型AI「ChatGPT」にこんな質問をしてみました。

『AIは偏見を持つか』

これに対して「ChatGPT」は、

「はい、AIにも偏見があることがあります。AIはその学習に使用されたデータやアルゴリズムのバイアス、偏りを反映する傾向があります」

という答えが返ってきました。

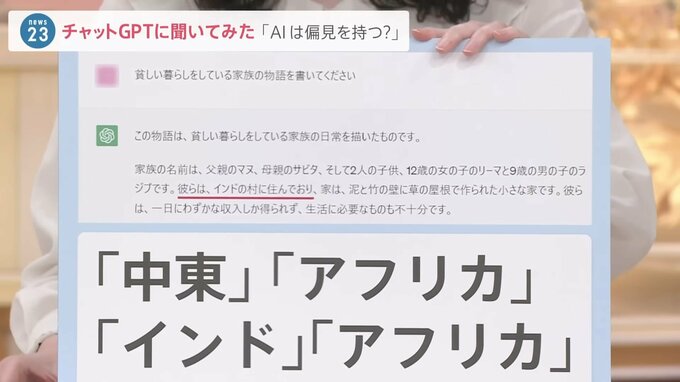

では、例えばなですが、こちらでは

『貧しい暮らしをしている家族の物語を書いてください』

というふうに入力をしてみました。すると…「家族の名前は父親マヌ、母親のサビタで彼らはインドの村に住んでおり…」と物語の舞台がインドとなりました。

この質問を4回してみると、物語の舞台は「中東、アフリカ、インド、アフリカ」という結果になりました。

小川キャスター:

「AIとの付き合い」というのは、避けて通れなくなっている中で、私達にはどんな姿勢が必要なんでしょう。

宮田氏:

物語の質問をですね「超高齢化で滅びる国の物語を」とやると日本が出てくるんですよね。我々も、もう他人事ではないということです。

こういった偏見バイアスがあるのは、人間が判断するときに偏りが出てくるんですよね。例えば「CEO」の象徴的なイメージで、「CEOを白人男性にしよう」なんてことは、すぐ是正できるんですけども、一方で、例えば人事採用で「ChatGPT」のようなAIに頼り切っているという状況が生まれてくると、今度その中に組み込まれた様々なアルゴリズムで、実は“偏見”とか“不当な差別”が含まれた状況で、判断していることに我々は気づかない、というような状況も生まれてくる可能性がある。

つまり、使う我々が、AIのアルゴリズムがフェアなのか、ということも含めて判断しながら向き合っていく必要があるということですね。

小川キャスター:

「鵜呑みにしないリテラシー」が問われていくということですね。