AI技術で住民の情報をデータ化 攻撃対象を抽出

イスラエル軍による攻撃で、3万5千人を超える犠牲者が出ているガザ。その攻撃に、AI技術を利用している実態が明らかになりました。

それが「ラベンダー」と呼ばれるAIシステム。現地の調査報道によると、ガザの住民およそ230万人の情報をデータ化し、ハマスなどの戦闘員と疑われる人物を、ラベンダーが攻撃対象として抽出。

全く関係ない人物を特定してしまうミスが、指摘されているにもかかわらず、空爆を判断する人間が、標的を確認してから攻撃を許可するまでの時間が、わずか20秒だったケースもあったといいます。

このラベンダーにとどまらず、イスラエルは、人間を介さず、AIが独自に攻撃を判断する「自律型AI兵器」の開発も進めています。

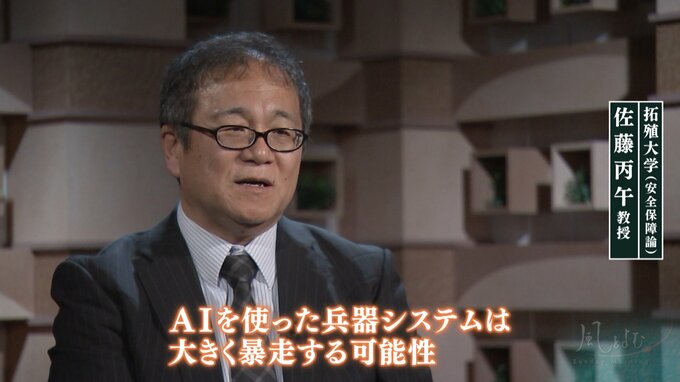

AI技術の軍事転用に専門家は「大きく暴走する可能性」

AI兵器の開発にどう歯止めをかけたらいいのか、3月に行われた、その規制を巡る国連の会議では…

ロシア代表

「ここで将来の開発に影響をもたらす性急な決定をすべきではない」

規制に慎重な姿勢を崩さない国もあり、議論はかみ合わないまま。AIという先端技術まで軍事転用される現状に、専門家は…

拓殖大学:佐藤丙午教授(安全保障論)

「AIを使った兵器システムは、大きく暴走する可能性、機械が独自に判断して解釈し(攻撃を)行っていく怖さがある。そうなった時に、我々は機械に動かされて戦争をすることになってしまいますので、そこの怖さっていうのを、我々は十分認識すべき」

ダイナマイトを発明したノーベル。そして、原爆の父と呼ばれたオッペンハイマー。ともに、自らの生み出した技術や兵器が、多くの犠牲者をもたらしたことの責任を感じ、心の痛みにさいなまれました。

AI技術が戦争に利用され、多くの命を奪うこととなった場合、その責任は一体誰が負うのでしょうか?

(「サンデーモーニング」2024年5月19日放送より)