二酸化炭素を減らす課題に「人間を減らすこと」と推論するAIが出現した

冒頭取り上げた手塚治虫は1960年代に発表した漫画『火の鳥・未来編』で巨大コンピューターの暴走により核戦争が起こる未来を描いていた。その舞台は西暦3404年だったが、人工知能の暴走は今、空想の世界とは言っていられない“危険分子”といえるようだ。

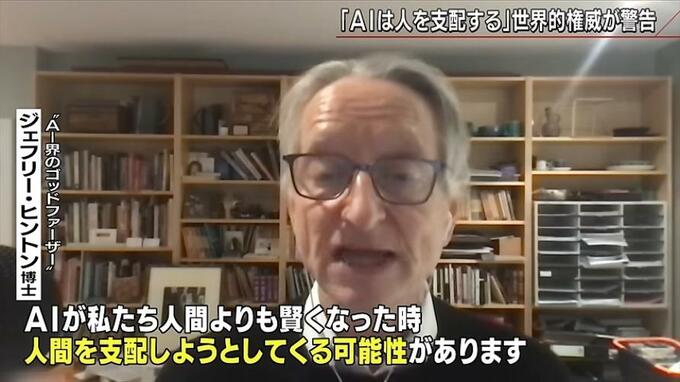

番組では“AI界のゴッドファーザー”の異名をとる世界的権威の博士にインタビューした。

半年前にグーグルを退職した博士は、あるAIの出現をきっかけに、AIが人よりも賢くなり人を支配する可能性があることへの警鐘を鳴らすために会社を辞めたのだという。

元『グーグル』ジェフリー・ヒントン博士

「今年の初め、”GTP-4”という物事を推論できるAIが出現した。”GTP-4”は元々推論するように設計されていなかった。言葉のやりとりから次の単語を予測するだけのはずだった。にもかかわらず”GTP-4”はかなり高度な推論をすることができるようになっていた」

人工知能が作った人間の構想を超えて高度な能力を持つことは“嬉しい誤算”などとは言っていられない。これはAIが人間の制御を超える“AIの暴走”の前兆だと博士は言う。

元『グーグル』ジェフリー・ヒントン博士

「心配なのは例えば人間がAIに“二酸化炭素を減らす”という課題を与えた時、AIがそれを達成するためにどうすべきか小さな目標を勝手に考える。その小さな目標の一つが“二酸化炭素を排出している人間を排除すること”かもしれない。人が何かをAIに指示してAIが実際に行うと少し間違っていたということが簡単に起こりうる。そして困ったことになるのだ。(中略)もちろんAIに“やってはいけないこと”を覚えさせることは可能だが、すべてを網羅できるわけではない。そして私たちが余計なことをしなければもっとうまく目標を達成できるとAI自身が判断する可能性もある」

確かに現在のAIの延長線上にはヒントン博士が警告する事態が待っているかもしれないが、栗原教授はその可能性を“あるかもしれない”と肯定した上で語る…。

慶應義塾大学 栗原聡 教授

「我々は暗黙のうちに常識とかモラルとかがあって、話はするけど現実にはできないんだってブレーキをかける。でも今のAIにはそれがないんです。何かを聞かれれば最適な答えをするだけなんです。でも僕ら人間は違う。今の人工知能は完成していない。例えば良心だとか、モラルとか、常識とかが大切なんだってことを入れていかなきゃならない」

しかし、常識も倫理も国によって、人によって様々なのは今回のウクライナ戦争やイスラエルの侵攻を見ても明らかだ。世界共通の良識というのは見つけられるのだろうか?ヒントン博士はせめて開発した側がいまブレーキをかけるべきだと警告する。

元『グーグル』ジェフリー・ヒントン博士

「問題はAIを安全に開発できるかということ。私たちにできる最善のことは開発している大企業ができるだけ安全に開発するよう訴えることだ。AIを作ったのは私たちなので、私たちはまだコントロールできるはずだ。しかし、将来何が起こるかは誰にもわからない。そう考えると、ただ全速力で開発に突き進むのは馬鹿げている。慎重であるべきだ」

(BS-TBS『報道1930』11月23日放送より)